Растим SEO-трафик до 200к и делаем 1,8 млн рублей в месяц

В этой статье я расскажу как дожимать до топа в Яндексе и Google в современных реалиях. Здесь будут представлены: специфическая ситуация по кейсу, практические данные по решению поставленных задач и свежайшие цифры.

Оглавление кейса:

Дано

В начале года к нам обратилась блогерка с рядом задач по своему проекту. Помимо раскачки соц. сеток также велись работы по информационному сайту, но трафик стагнировал и конкуренты давили довольно сильно не чураясь черных методов.

- Возраст домена: 1 год.

- Тематика: курсы по детскому питанию.

- Поисковый трафик в месяц: 130-150к уников.

- Массовая негативная накрутка ПФ: прямые заходы, поддельный реферер, трафик с Яндекса.

- Для негативного эффекта в Google конкуренты подклеивали токсичные дропы.

- Массовое воровство контента с последующим размножением на множестве мусорных сайтов.

Самый кайф ниши в том, что курсы не нужно проводить в онлайне или офлайне, они все сделаны в записи и их активно покупают новоиспеченные родители. А это значит, что при увеличении поискового трафика будет наблюдаться прямо пропорциональная корреляция по $ в кассе.

Воронка выглядит так:

- Родитель ищет информацию в поиске Яндекса/Google по информационным запросам.

- Попадает на посадочную страницу сайта с раскрытием тематики.

- В статье расставлены баннеры с CTA купить продвинутый курс.

- При клике идет перенаправление в чат-бота, автоматизированная оплата и отгрузка платного контента.

Схема простая и идеальная. Всё, что связано с детской тематикой - это вечнозелёные темы. Дети рождаются и будут рождаться постоянно. Приток новых родителей, которые создают поисковый трафик, был и будет постоянный. В тематике относительно много трафика и есть где развернуться. Там есть деньги, поэтому конкуренция достаточно жесткая.

Выстраивая план работ мы учли, что не имеет никакого смысла достраивать дом, пока он горит. Иными словами - нет смысла причесывать внутреннюю оптимизацию, работать с контентом и ссылками, пока не устранены внешние негативные факторы, мешающие развитию проекта.

Основная работа по проекту

- Защита сайта от негативной накрутки и конкурентной разведки.

Негативная накрутка поведенческих факторов крайне отрицательно сказывается на дальнейших перспективах проекта. Ранее для защиты сайта мы использовали два барьера защиты: Cloudflare и AntiBot.Cloud.

От Cloudflare было решено отказаться, так как весь год идут веерные блокировки сайтов в рунете, и очень велик шанс, что общий ip Cloudflare может попасть под раздачу. Сменить ip-адрес в Cloudlfare можно только на премиум-тарифах через техподдержку.

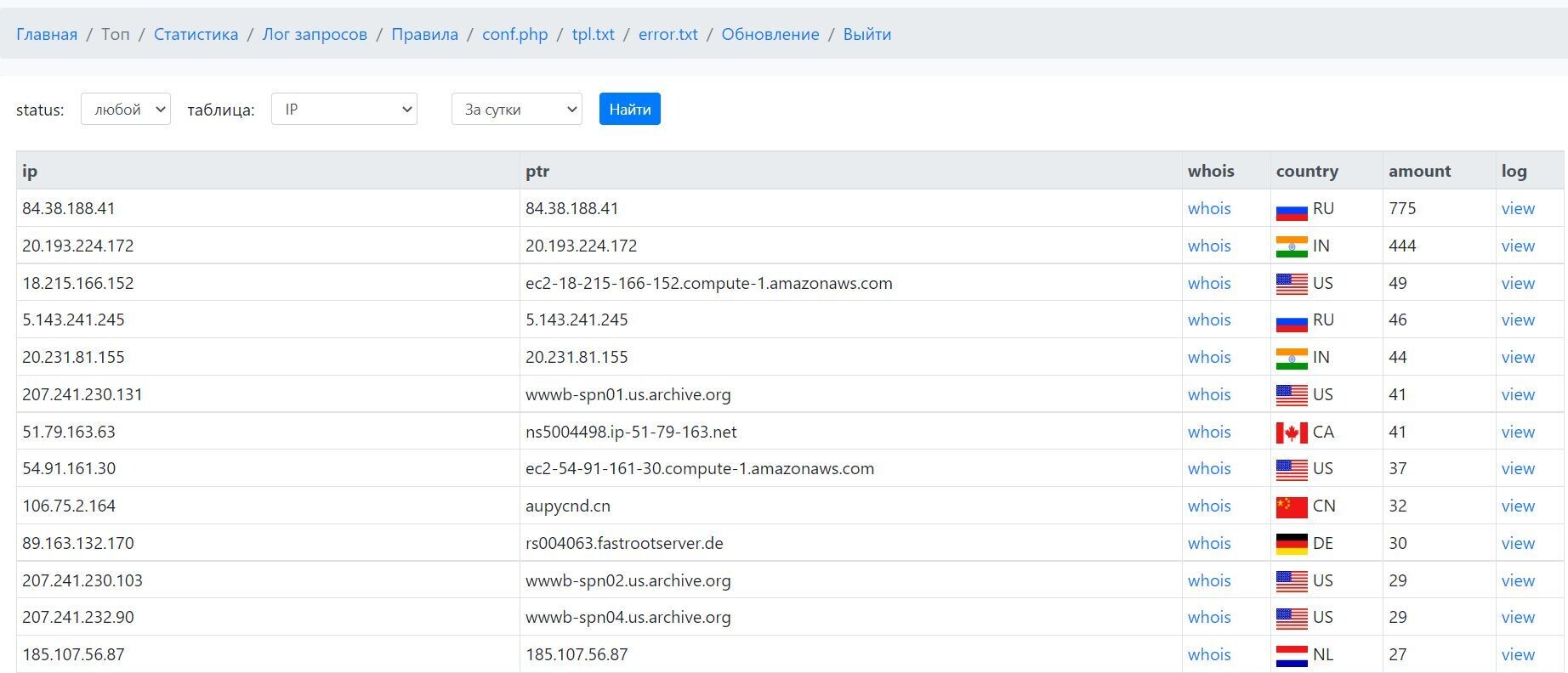

Проект Antibot развивается и на данный момент является лучшей защитой от паразитного трафика, а так же парсеров и сервисов по анализу сайтов. Сразу после установки и настройки фаервола с пачкой кастомных правил негативная накрутка ПФ была устранена.

Наиболее ярко выражено это видео по прямым заходам:

Большинство пользователей с белыми fingerprints, cookies и ip проходят проверку автоматически и не замечают работы фаервола. Подозрительным пользователям и ботам показывается окно в выбором цвета:

Поведенческие боты, парсеры и средства конкурентной разведки фильтруются замечательно и не могут получить доступ к проекту. Яндекс.Метрика таких ботов также не видит, в cookies бота будут отсутствовать записи о посещении сайта.

При анализе статистики мы получаем исчерпывающие данные по посещениям, включая ip, заголовки, рефереры. Вся эта информация в дальнейшем используется для выявления сайтов, которые воруют контент через парсинг в автоматическом режиме, и более тонкой настройки блокировок на уровне веб-сервера.

С таким фаерволом мы обеспечиваем:

- защиту от поведенческих и спам-ботов;

- защиту от любых парсеров (прокси, http-заголовки и user-agent не имеют значения);

- защиту от фейк-ботов с user-agent как у официальных роботов поисковых систем;

- защиту от проксирования сайта дорвеями;

- проверку ботов по PTR-записям;

- снижение нагрузки на веб-сервер.

При этом Antibot не препятствует нашим ботам для положительной накрутки ПФ. Для этого перед переходом на сайт из Яндекса наши боты переходят сначала на секретный url с php скриптом, где каждый бот получает секретный cookie-ключ. Далее боты производят нужные манипуляции на сайте и значительно улучшают поведенческие факторы.

Защита от конкурентной разведки - так же большое преимущество, особенно в контентных проектах. Теперь проанализировать автоматически сотни страниц с контентом не получится, фаервол заблокирует все попытки, и конкурентам придется ковырять всё это в ручную, что доставляет максимальные неудобства.

- Ищем сворованный контент и вычищаем его из результатов поиска.

Дубли одного и того же контента негативно сказываются на ранжировании в поисковых системах. Нередки случаи, когда более трастовый сайт с украденным текстом ранжируется выше оригинала.

Для поиска сайтов, которые украли тексты с продвигаемого проекта достаточно использовать программу eTXT Антиплагиат. Далее получаем список точных url и готовим подробные заявления в Google и Яндекс.

В Google - создали новое заявление через специальную форму. Специалист отдела DMCA реагирует достаточно быстро. Они выявляют первоисточник и удаляют из результатов поиска воришек. Могу запросить дополнительную информацию в тикетах.

В Яндексе - создали тикет о нарушении авторских прав через форму. Платоны реагируют немного медленнее и неохотнее. Был прецедент, когда присылали отписку. В этом случае намёк на судебное разбирательство ускоряет процесс.

Для исключения проблем с воровством контента мы настроили быструю индексацию новых страниц через Google Index API, а в Яндексе достаточно молниеносно добавлять новые или обновленные url на переобход в Яндекс.Вебмастер.

В результате: сайты с копипастом в Google вообще пропали из результатов поиска, а в Яндексе они были на 2 странице, но после обращения в поддержку и пару апдейтов сползли в небытие.

Теперь с фаерволом украсть контент можно только вручную, что немного трудоёмко, особенно если нет специальных знаний. Рекомендую периодически следить не своровали ли с вашего сайта ваш контент и своевременно обращаться за помощью в поддержку поисковых систем.

Это может быть причиной стагнации или отсутствующего роста.

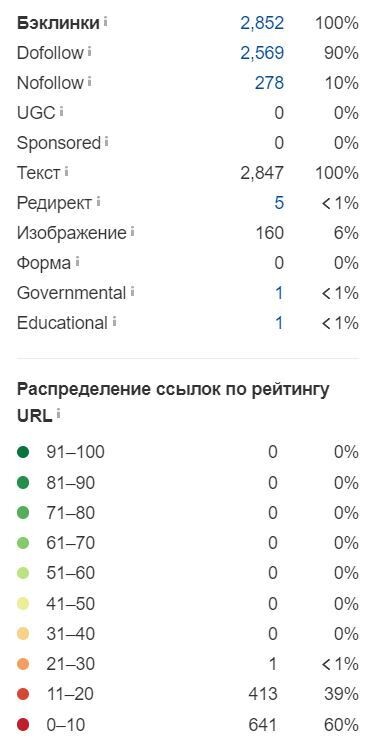

- Ищем токсичные ссылки и просим Google не учитывать их.

Бытует мнение, что токсичные бэклинки вообще можно не чистить, и Google сам решает какие ссылки учитывать, а какие нет. И это мнение имеет место быть на практике.

Однако, для стопроцентной уверенности, лучше всего выявить мусорные ссылки и принудительно запретить их через Disawov Tool.

Для анализа ссылочного профиля лучшим инструментом является Ahrefs и я им пользуюсь на постоянной основе.

Довольно быстро можно сообразить какие данные лучше выгрузить в файлик.

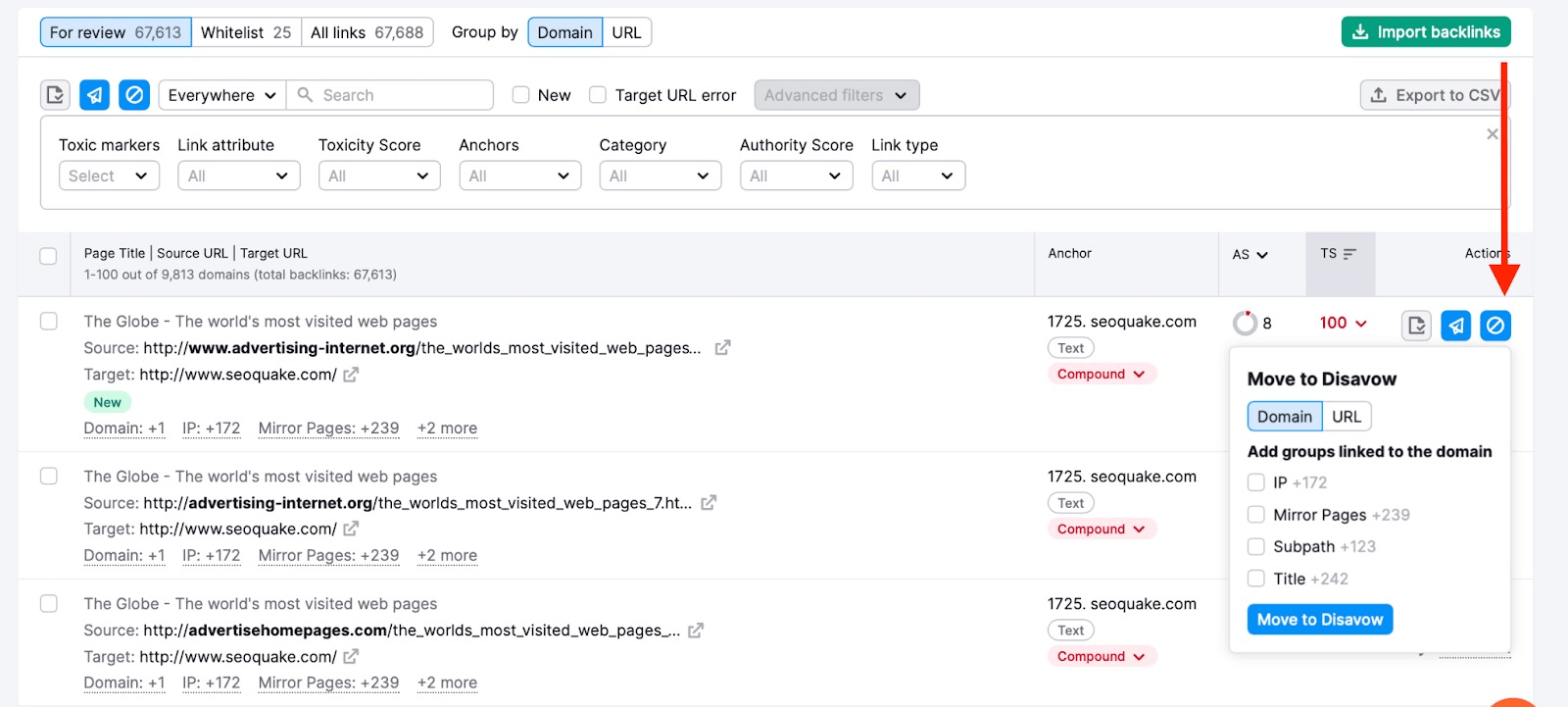

В качестве второго сервиса для поиска токсичных url мы используем Semrush. В нем присутствует метрика Toxic Score. Чем выше параметр в диапазоне от 0 до 100, тем хуже ссылка.

Здесь так же можно быстро сориентироваться и подготовить уже готовый файл для Disavow Tool.

После загрузки файла мы даём Google рекомендации, какие ссылки не хотим учитывать для нашего домена. При регулярном обновлении файла Google обучает свой алгоритм и в дальнейшем с большой вероятностью не будет учитывать мусорные бэклинки в автоматическом режиме.

- Устраняем внутренние технические проблемы с сайтом.

После полного сканирования сайта SiteAnalyzer'ом были исправлены: дубли страниц пагинации, дубли контента по разным url (особенность cms), дубли страниц с параметрами.

Всегда стоит проверять какие сайты еще размещены на ip-адресе веб-сервера хостинг провайдера. Среди соседей мы обнаружили гэмблинг, бады и адалт сайты. Было решено переехать на выделенный ip-адрес через заявку в техподдержку.

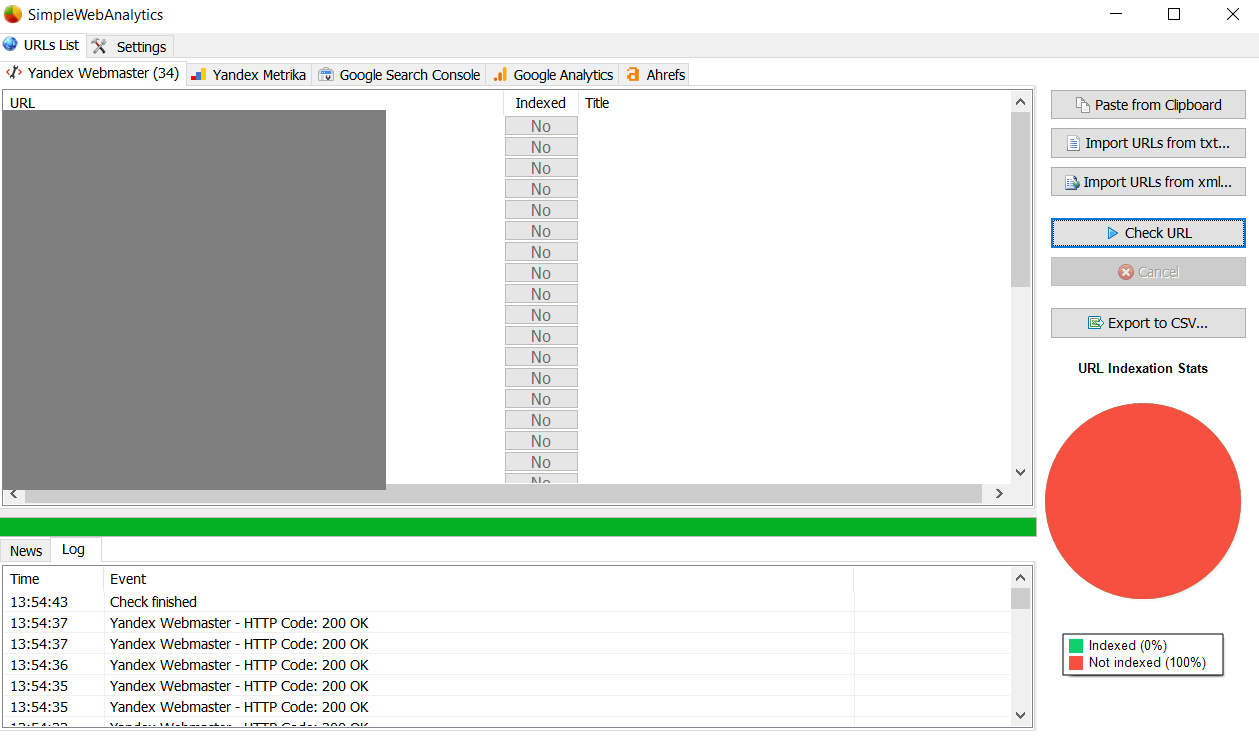

- Устранение проблем с индексацией сайта.

В Яндексе и Google количество страниц в результатах поиска по сайту может отличаться. Это говорит о возможных проблемах в той или иной поисковой системе.

Чтобы быстро проверить индексацию мы используем софт SimpleWebAnalytics. Он получает данные по API и имеет функционал экспорта для дальнейшего анализа. Можно быстро определить не только статус индексации, но и мета-теги, применились изменения или нет.

Были выявлены проблемы с индексацией в Яндексе, некоторые страницы попали под МПК фильтр. Решением была накрутка ПФ по определенным сценариям с посещением проблемных страниц. Через неделю после апдейта страницы начали ранжироваться. Данный метод работает в множестве проектов.

Чтобы не допускать отвала страниц мы проектируем внутреннюю перелинковку и следим, чтобы нужные страницы получали достаточно поведенческих факторов.

- Контроль скорости работы страниц сайта.

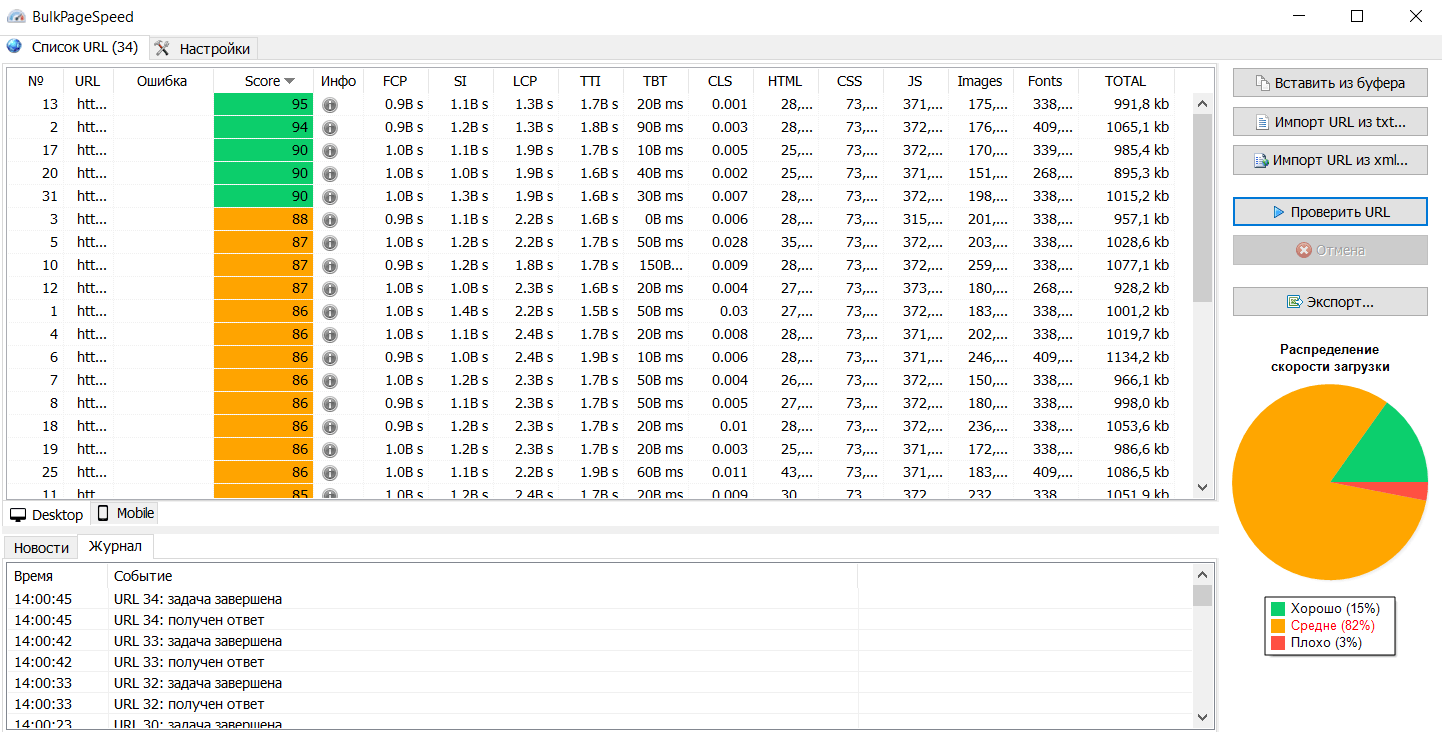

В коммерческом проекте скорость работы сайта является важным параметром. Важно, чтобы каждая страница открывалась не более чем 3 секунды. И лучше всего, чтобы была хотя бы в жёлтой зоне PageSpeed Insights. На самом деле это уже перфекционизм. В рунете спокойно ранжируются в топе Google сайты с красной зоной по скорости работы.

Для контроля скорости работы страниц сайта, а также соответствия требованиям PageSpeed Insights, мы используем софт BulkPageSpeed.

ачем проверять вручную сотни и тысячи url? Пускай это будет автоматизировано. Всё что нам нужно - получить API ключик в Google.

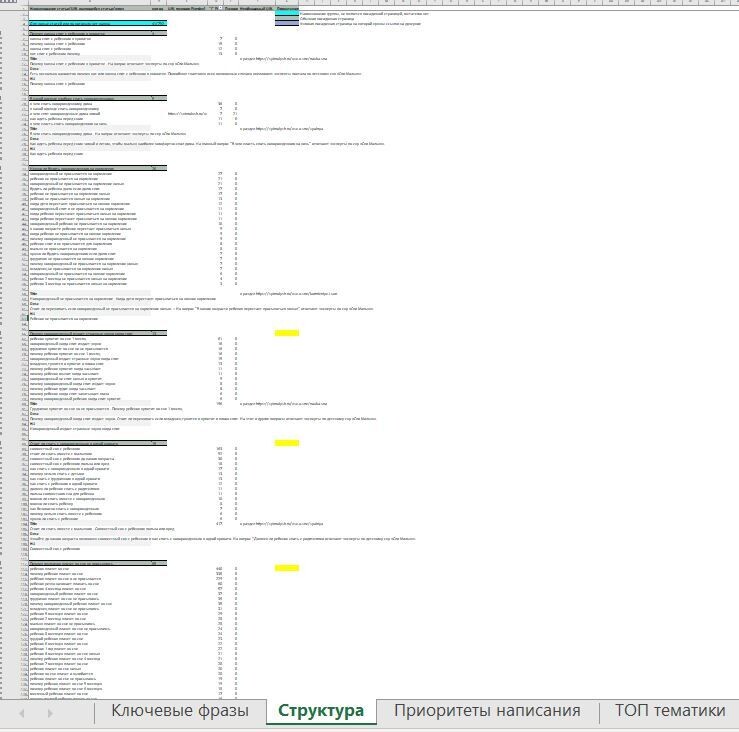

- Ресерч семантики.

Всю работу с семантикой мы поделили на два блока: актуализация внедренной семантики и внедрение новых кластеров. Для этого мы используем keyword research tool от Ahrefs. В нем есть самая полная и крутая база под Google и не менее крутая для Яндекса.

Можно использовать Keys.so или что-то подобное, не суть важно, алгоритм работы плюс минус одинаковый.

В итоге текущую семантику расширили на 3600 фраз и собрали новую на 5900. Далее всё сводится в единый файл с кластеризацией и мета-тегами.

В нем же даны рекомендации по общей структуре сайта и приоритетам для оптимизации новых статей и оптимизации текущих.

- Прочие работы.

Ведется большая работа по наращиванию ссылочной массы для проекта, так как по аналитике из Google больше всего конверсий и трафика. Работа с копирайтингом достаточно заурядная и сводится к составлению ТЗ и дальнейшей проверке готового текста от копирайтера.

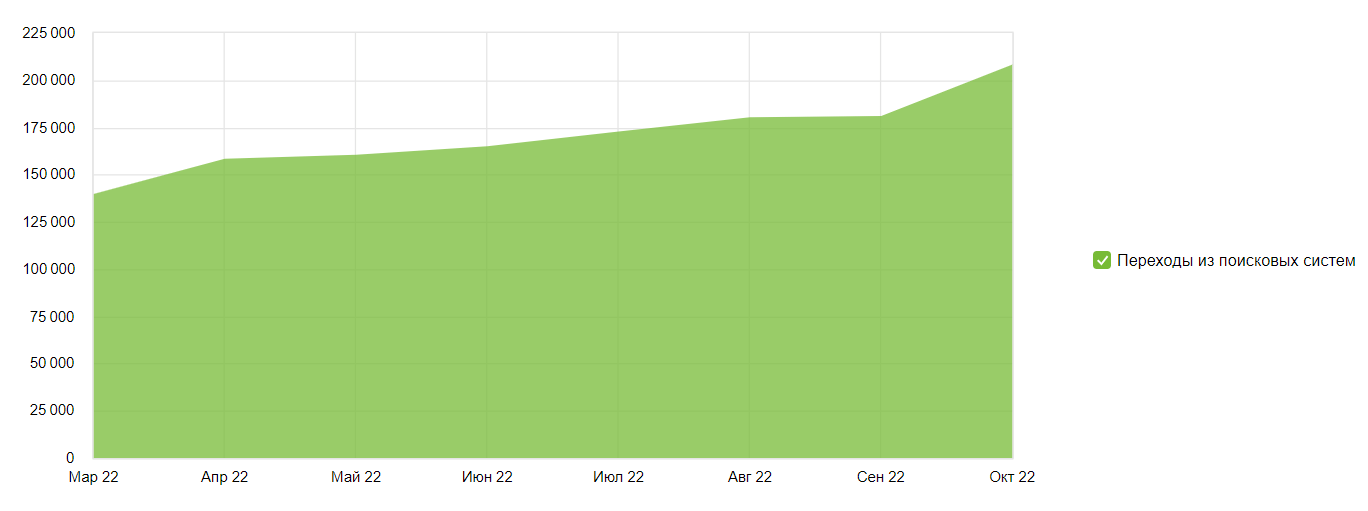

Результаты

Основным результатом для информационного проекта является динамичный рост трафика с последующей монетизацией.

Было: падающий тренд, ~150 000 уников с поиска в месяц..

Стало: растущий тренд, более 200 000 уников в месяц с поиска.

Конверсия в оплату: 0,23%.

Продаж в месяц: ~260.

Чистая прибыль в месяц: ~ 1 800 000 рублей.

Что влияет на результат?

- постоянное добавление нового контента;

- периодическое обновление контента;

- активная защита от ботов и парсеров;

- хорошие ПФ;

- положительная динамика по росту ссылок;

- контент дорогой и экспертный;

- слаженная системная работа по SEO.

В скором времени будет апдейт этого кейса, так как за счет большого потенциала в нише по нашим прогнозам трафик в течении года удвоится.

Артём Акулов

Артём Акулов